- ControlNet es un complemento de Stable Diffusion

- Se puede usar para controlar a detalle los resultados de tus prompts

- ControlNet es de código abierto

Lo único con lo que los generadores de inteligencia artificial de texto a imagen han estado luchando son las manos. Si bien las imágenes son generalmente impresionantes, las manos lo son menos, con dedos superfluos, articulaciones extrañas y una clara falta de comprensión de cómo se supone que deben verse las manos por parte de la IA. Sin embargo, esto no tiene por qué ser así, ControlNet está aquí para ayudar a crear manos perfectas con Stable Difussion.

ControlNet es una nueva tecnología que te permite usar un boceto, un contorno, una profundidad o un mapa normal para guiar a las neuronas basadas en Stable Difussion 1.5. Esto significa que ahora puedes tener manos casi perfectas en cualquier modelo personalizado 1.5 siempre y cuando tengas la guía correcta. ControlNet puede ser considerado una herramienta revolucionaria, permitiendo a los usuarios tener un control total sobre sus diseños.

Requisitos para lograr manos perfectas con Stable Diffusion

Para lograr manos impecables, usa la extensión Automatic1111 con ControlNet, específicamente el módulo de profundidad. Luego, toma algunas selfies de cerca de tus manos y cárgalas en la pestaña “txt2img” de la interfaz de usuario de ControlNet.

Luego, crea una simple frase para moldear el sueño, como “obra de arte de fantasía, hombre vikingo mostrando manos de cerca”, y experimenta con el poder de ControlNet. De esta manera, la experimentación con el módulo de profundidad, la extensión Automatic1111 y la pestaña “txt2img” de la interfaz de usuario de ControlNet dará como resultado manos hermosas y realistas.

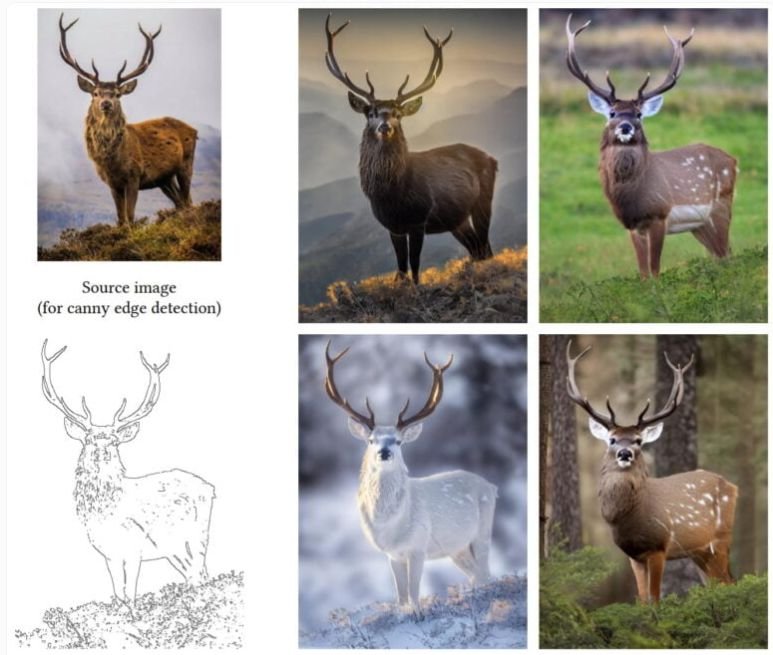

ControlNet convierte la imagen que se le proporciona en profundidad, normales o un boceto para que luego pueda ser utilizada como modelo. Pero, por supuesto, también puedes cargar directamente tu propio mapa de profundidad o bocetos. Esto permite una máxima flexibilidad al crear una escena 3D, lo que te permite centrarte en el estilo y la calidad de la imagen final.

ControlNet mejora increiblemente el control sobre el modulo image-to-image de Stable Diffusion

Del mismo modo que Stable Diffusion puede crear imágenes a partir de texto, también puede crear gráficos a partir de plantillas. Este proceso de imagen a imagen se utiliza con frecuencia para mejorar las fotos generadas o para producir nuevas imágenes desde cero utilizando plantillas.

Si bien Stable Diffusion 2.0 ofrece la capacidad de utilizar datos de profundidad de una imagen como plantilla, el control sobre este proceso es bastante limitado. Este enfoque no es compatible con la versión anterior, 1.5, que todavía se utiliza comúnmente debido al gran número de modelos personalizados, entre otras razones.

Los pesos de cada bloque de Stable Diffusion son copiados por ControlNet en una variante entrenable y una variante bloqueada. La forma bloqueada conserva las capacidades del modelo de difusión listo para la producción, mientras que la variante entrenable puede aprender nuevas condiciones para la síntesis de imágenes mediante un ajuste fino con pequeños conjuntos de datos.

En conclusión, Stable Diffusion funciona con todos los modelos de ControlNet y ofrece considerablemente más control sobre la IA generativa. El equipo proporciona muestras de variaciones de personas en poses fijas, así como diversas fotos de interiores basadas en la disposición espacial del modelo y variaciones de imágenes de aves.